Anfang 2018 hatten wir über eine Arbeit berichtet, die mit den besten zur Verfügung stehenden Daten die Empfindlichkeit unseres Klimasystems auf eine Veränderung des CO2-Gehaltes der Atmosphäre herleitete (Dafür ist auch der Begriff Klimasensitivität genräuchlich). Lewis/Curry (2018) kommen zum Ergebnis:

1,3°C für eine Verdopplung des CO2-Gehaltes der Atmosphäre bis etwa zum Ende dieses Jahrhunderts (Transient Climate Response), 1,7°C für ein langfristiges Gleichgewicht (ECS) etwa im Zeitraum 2150 bis 2200. Die Zahlen reagieren kaum empfindlich auf die Wahl von Zeitfenstern, sie schwanken nur sehr wenig, ob man 1870†¦2016 auswertet oder 1930†¦2016. Es gab eine ganze Reihe von Vorläuferarbeiten auch anderer Autoren, die ebenfalls etwa diese recht geringen Werte fanden. Auch Arbeiten, die historische Zeiträume (letztes glaziales Maximum bis vorindustriell) unter die Lupe nahmen, widersprechen diesen niedrigen Zahlen nicht.

Wie wir schon häufiger ausgeführt haben, laufen die Klimamodelle zu heiß, sie rechnen mit einer zu hohen ECS- im Mittel liegen sie bei 3°C. Dass diese Modelle nicht einmal die vergangenen 30 Jahre richtig wiedergeben können und daher die Modelle künstlich für diese Zeit mit einer um ein Drittel und mehr verringerten Sensitivität rechnen, hat Steve Koonin (Under Secretary for Science unter Präsident Obama von 2009 bis 2011) vor geraumer Zeit auf einem Hearing der American Physical Society (S. 255) offenbart. Das IPCC nennt das scaling (WG 1, Chapter 10, S. 882), auf deutsch was nicht passt, wird passend gemacht. Denn für die Zukunft rechnen die Modelle dann wieder mit der um ein Drittel höheren Sensitivität.

Können die IPCC-Modelle vor der Empirie gerettet werden?Wenn Modelle und Wirklichkeit nicht zusammenpassen, sollten eigentlich Wissenschaftler eher ihre Modelle in Frage stellen. Das hieße, die viel dramatischeren Sensitivitäts- Abschätzungen der letzten IPCC-Modellbetrachtungen - 1,86°C für TCR und 3°C für ECS - müssten über den Haufen geworfen werden. Die IPCC-Wissenschaftler stellen sich eher die Frage, wie können die IPCC Modelle mit ihren besorgniserregenden Projektionen vor der Empirie gerettet werden? Denn daran hängt ja der ganze Alarmismus, der die westlichen Gesellschaften prägt, von Fridays for Future bis zur CO2-Steuer.

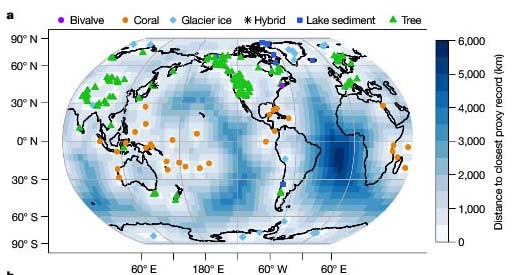

Ein Schlüsselargument bisher geht so: Modelle sagen eine andere räumliche Verteilung der Erwärmung der Ozeane voraus als das, was wir beobachten. Es könnte also durchaus sein, so Aktivisten, dass die Abweichung eine „Laune der Natur“ wäre, eine interne Variabilität, und nach Beendigung dieser eher zufälligen Episode die Erwärmung „modellkonform“ viel stärker wird im globalen Maßstab. Und daher versucht das IPCC mit allem Krampf, im nächsten Bericht wieder eine viel zu hohe CO2-Sensitivität durchzudrücken. Hier nun leisten zwei aktuelle Arbeiten Aufklärung. Um es vorweg zu nehmen: Die Beobachtungen der Erwärmungsrate sind korrekt, die abweichenden Muster der Klimamodelle entstehen durch ihre Unzulänglichkeiten, und die Muster werden sich auch nicht ändern.

Die IPCC-Modelle sehen beispielsweise als Ergebnis des menschgemachten CO2-Antriebs eine recht gleichmäßige Erwärmung des tropischen Pazifiks. Die Beobachtungen jedoch stellen eine bedeutend stärkere Erwärmung des westlichen tropischen Pazifiks gegenüber dem östlichen fest.

In Dong et al (2019) weisen die Autoren nach, dass, wenn sich die konvektiven Regionen mit vielen Wolken des westlichen Pazifiks stärker erwärmen als die mit kaum Konvektion des Ostpazifiks, die globale Gesamterwärmung deutlich weniger ausgeprägt ist. Die Konvektion im westlichen tropischen Pazifik führt dazu, dass es eine verstärkte Abstrahlung von Wärme in den Weltraum gibt, die dortige Erwärmung also viel effektiver abgebaut werden kann, als dies bei einer stärkeren Erwärmung des östlichen Pazifiks mit geringerer Konvektion möglich wäre. Es ist also ein klarer physikalischer Mechanismus, der dazu führt, dass die beobachtete stärkere Erwärmung des tropischen Westpazifiks zu geringeren globalen Sensitivitäten (= stärkeres negatives globales Feedback) führt. Wieder einmal scheitern die Modelle an den Wolken!

Große Defizite in der Abbildung des GeschehensKlimamodelle haben so große Defizite in der Abbildung des Geschehens im tropischen Pazifik, dass sie dadurch die Antwort auf den Antrieb global falsch ermitteln und die Empfindlichkeit auf den CO2-Antrieb systematisch überschätzen, wie eine zweite Arbeit von Seager et al von der Columbia University in der angesehenen Wissenschaftszeitung "Nature" (!) vom Juli 2019 zeigt: "The failure of state-of-the-art models to capture the correct response introduces critical error into their projections of climate change". Konsequenzen? Keine. Ich habe Zweifel, dass die Ergebnisse der beiden bedeutenden Arbeiten überhaupt inhaltlichen Eingang in den kommenden Sachstandsbericht des IPCC finden werden. Dann nämlich müsste man hunderte Seiten kritisch überarbeiten, die sich mit Modellprojektionen beschäftigen.

Ein Grund mehr für uns, der Empirie zu vertrauen und nicht der „Playstation Klimatologie“. Aber was soll dann aus der „Panik“ werden, die uns „Fridays for Future“ verordnen wollen? Alles nur heiße Luft? Die Politik läuft heiß, weil die Modelle zu heiß laufen. Welche Wissenschaftler haben den Mut und sehen ihre Verantwortung, FFF und die Politik aufzuklären? Selbst wenn wir die CO2-Emissionen auf dem heutigen Niveau aufrechterhalten und nicht weiter steigen lassen, bleiben wir in diesem Jahrhundert unter 500 ppm und unterhalb von 2 Grad Erwärmung.